Após a entrada em vigor, a 1 de agosto de 2024, da primeira regulação, a nível mundial, que versa sobre Inteligência Artificial (IA)– o IA Act[1] – eis que no dia 2 de fevereiro de 2025 entraram em vigor os seus primeiro e segundo capítulos, respeitantes às suas disposições gerais, onde inclui a necessidade de ser assegurado um nível adequado de literacia digital, e às práticas proibidas de IA, respetivamente. O dispositivo do IA Act, como aquilatado em publicação anterior[2], adota uma abordagem baseada no risco e pretende dotar o recurso à IA de critérios de legalidade, segurança e proteção dos direitos fundamentais, sem prejuízo da promoção do investimento e da inovação em IA.

Neste conspecto, todas as empresas que se encontrem a operar em Portugal, ou qualquer outro Estado-Membro, e produzam, distribuam, integrem ou recorram a um sistema de IA[3] que tenha a si associado um risco inaceitável encontram-se, neste momento, em desconformidade com o IA Act e, não obstante a supervisão ser passível de ser já realizada[4], “só” a partir de 2 de agosto de 2025 é que estes operadores se encontram sujeitos à aplicação coimas num montante até 35 milhões de euros ou até 7% do seu volume de negócios anual, consoante o mais elevado[5].

Em que consistem as práticas proibidas de IA?

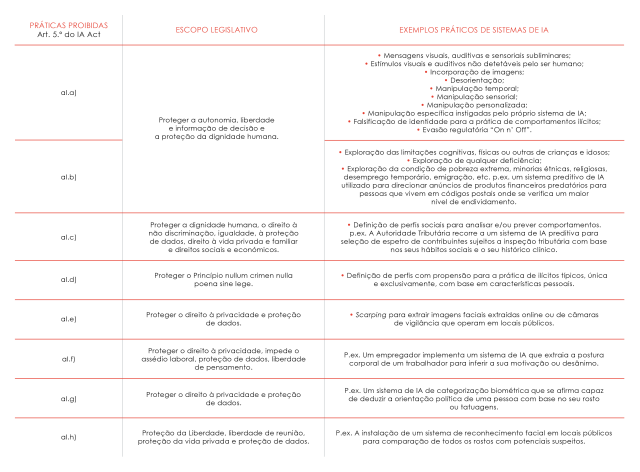

As práticas proibidas de IA encontram-se categorizadas como de risco inaceitável à segurança e aos direitos fundamentais dos cidadãos na União Europeia. A Comissão Europeia[6], no dia 04 de fevereiro de 2025, divulgou as guidelines, não vinculativas, acerca das práticas proibidas de IA, que permitem aclarar juridicamente e fornecer elementos cruciais para a interpretação, pelo tecido empresarial, das proibições elencadas no artigo 5.º, n.º1 do AI Act, as quais se prendem com a colocação no mercado, em serviço e/ou a utilização de sistemas de IA que recorram a:

- Técnicas subliminares ou manifestamente manipuladoras ou enganadoras [al.a)];

- Exploração de vulnerabilidades, devidas à idade, incapacidade ou situação socioeconómica [al.b)];

- Avaliação ou classificação social com base no comportamento ou características de personalidade [al.c)];

- Avaliação de risco de infração[al.d)];

- Criação ou expansão de bases de dados de reconhecimento facial, através da recolha de imagens da internet ou televisão [al.e)];

- Inferência de emoções no local de trabalho e estabelecimentos de ensino [al.f)];

- Sistemas de categorização com base em dados biométricos [al.g)];

- Identificação biométrica à distância em “tempo real” em espaços público [al.h)]; e

- Práticas proibidas por outros dispositivos europeus[7].

Nesta senda, e recorrendo aos exemplos, não taxativos, resultantes das orientações emitidas pela Comissão Europeia, serve o quadro infra para aclarar as referidas alíneas:

Existem exceções?

Sim, o artigo 2.º do IA Act prevê uma série de exclusões à aplicação do presente regulamento, as quais, por sua vez, também se subtraem à sua classificação como prática proibida à luz do artigo 5.º, além das presentes na interpretação das diversas alíneas, em concreto nas seguintes matérias:

- Finalidades militares, segurança e defesa nacionais;

- Cooperação judiciária e policial internacional;

- Investigação e desenvolvimento científicos;

- Atividade puramente pessoal sem cariz profissional.

Revertendo ao tema, um exemplo paradigmático e mediático de uma prática proibida, de risco inaceitável, à luz do art. 5.º do IA Act, é o vídeo[8] do Presidente ucraniano, Volodimir Zelensky, a anunciar a rendição da Ucrânia face à ofensiva militar russa. O vídeo aparenta ser autêntico e apenas numa análise mais cuidada é possível decifrar algumas imprecisões, como o movimento de cabeça e boca do Presidente, bem como diferenças na sua pronúncia, evidenciando tratar-se de uma “deepfake”. O recurso a “deepfakes” não é, por si só, uma prática proibida pelo IA Act, desde que verificados os requisitos de transparência do seu artigo 50.º. Não obstante, e no caso em apreço, foi utilizado um sistema de IA que empregou técnicas de manipulação cognitiva ilícitas, com recurso à falsificação de identidade, distorce a realidade, publicita a guerra, influencia politicamente a população ucraniana, almejando que a mesma tome uma decisão que noutra circunstância não tomaria.

Mas tudo é negativo? Não, a IA além de permitir mais celeridade e agilidade procedimental, tem permitido um enorme avanço na ciência e a própria proteção da vida humana, como é o caso de sistemas de IA que detetam estados depressivos e permitem impedir o suicídio.

As empresas estão preparadas para o novo regime jurídico? A regulação de IA não é uma discussão para o futuro, é uma realidade do presente, e as empresas que ainda não iniciaram esta transição encontram-se em incumprimento e sujeitas a procedimentos de fiscalização, pelo que urge que o tecido empresarial que produz, implementa ou utiliza sistemas de IA implemente mecanismos de conformidade, por forma a evitar riscos regulatórios, sancionatórios, operacionais, financeiros e reputacionais, e promovendo a integridade da sua marca. Recorde-se que, a partir do dia 2 de maio de 2025, as empresas serão obrigadas a ter os seus próprios códigos de conduta de utilização responsável de IA, pelo que a implementação de um Programa de Compliance e Governance para a utilização de IA, direcionado à utilização e setor em que a empresa opera, é algo que deva ser pensado no imediato. Este programa de Compliance e Governance deve ser razoável equilibrando a segurança, a ética e o cumprimento normativo pelo sistema de IA com a inovação ao mesmo associada, devendo contemplar as seguintes matérias:

- Programas de literacia e capacitação em IA;

- Due diligence aos sistemas de IA e classificação dos riscos associados;

- Criação de políticas de mitigação dos riscos apurados;

- Auditoria e monitorização contínuas.

por Nuno da Silva Vieira e Ana Peixoto, Área de Prática – TMT – Tecnologia, Media e Telecomunicações

[1] Regulamento (UE) 2024/1689 do Parlamento Europeu e do Conselho de 13 de junho de 2024.

[2] https://adcecija.pt/inteligencia-artificial-ai-act-entre-inovacao-regulacao/.

[3] Na aceção do artigo 3.º, 1) do AI Act.

[4] Em conformidade com o artigo 77.º do AI Act, foi nomeada a ANACOM como entidade que assegurará a articulação entre as 13 entidades responsáveis pela supervisão do cumprimento com o IA Act e a proteção dos direitos fundamentais.

[5] Regime sancionatório previsto no Capítulo XII do AI Act, concretamente nos artigos 99.º, n.º 3 e 113.º, b).

[6] Em cumprimento do artigo 96.º, n.º 1, alínea c) do AI Act. Encontrando-se as orientações disponíveis em: https://digital-strategy.ec.europa.eu/pt/library/commission-publishes-guidelines-prohibited-artificial-intelligence-ai-practices-defined-ai-act.

[7] Proibição expressa no n.º 8 do artigo 5.º do IA Act.

[8] Disponível em: